大模型加速涌向移动端!ControlNet 手机出图只需 12 秒,高通 AI 掌门人:LLaMA 也只是时间问题

大规模模型的革新浪潮正在迅猛地涌向移动应用领域。不久前,在 MWC 上,高通公司展示了一项引人瞩目的技术:仅用 15 秒的时间,通过手机运行稳定扩散算法,即可生成精美的图片。

大规模模型的革新浪潮正在迅猛地涌向移动应用领域。不久前,在 MWC 上,高通公司展示了一项引人瞩目的技术:仅用 15 秒的时间,通过手机运行稳定扩散算法,即可生成精美的图片。

而在之后的 CVPR 2023 大会上,参数规模进一步扩大至 15 亿,并且 ControlNet 已成功登陆手机端,只需不到 12 秒便能完成图像生成。

更令人惊讶的是,高通技术公司的产品管理高级副总裁兼 AI 负责人 Ziad Asghar 透露,从技术角度来看,将这些 10 亿 + 参数的大规模模型迁移到手机上,仅需不到一个月的时间。

而这仅仅是一个开始。Ziad 认为,“大模型正在迅速重塑人机交互的方式。这会让移动应用的使用场景和使用方式发生翻天覆地的变化。”每个看过《钢铁侠》的人都无法不向往拥有无所不能的助手贾维斯。

尽管语音助手早已不再新奇,但与科幻电影中的智能助手相比,它们仍有一些差距。然而,在 Ziad 看来,大规模模型将成为打破这一状况的决定性因素。大规模模型具备真正重塑我们与应用互动方式的能力。而这种变革的一个具体表现就是“全能型”。

也就是说,通过大规模模型赋能的数字助手,用户可以通过自然语言指令在手机这样的终端上操控一切:无论是办理银行业务、撰写电子邮件、制定旅行计划还是订票等等各种操作,一应俱全。

更为重要的是,这样的数字助手还能够实现“私人订制”。结合手机上的个性化数据和能够理解文字、语音、图像、视频等多种输入模态的大语言模型,数字助手可以更准确地把握用户的喜好。而且,在不牺牲隐私的前提下,个性化体验得以实现。

从技术角度来看,这其中的关键在于将稳定扩散和 ControlNet 融入手机的混合 AI 架构,并借助量化、编译和硬件加速等 AI 技术提供支撑。

所谓的混合 AI,是指终端和云端协同工作,灵活分配 AI 计算负载,以更高效地利用计算资源。而量化、编译和硬件加速优化则是实现混合 AI 的关键 AI 技术,受到高通等终端 AI 厂商的长期关注和投入。

量化是指在保持模型精度的前提下,将更大的模型从浮点数转换为整数,从而节省计算时间;或者通过对模型进行压缩,保证性能的同时减小模型的大小,使其更易部署在终端设备上。

编译器是 AI 模型以最高性能和最低功耗运行的关键。AI 编译器将输入的神经网络转化为能够在目标硬件上运行的代码,并通过优化来提高时延、性能和功耗。

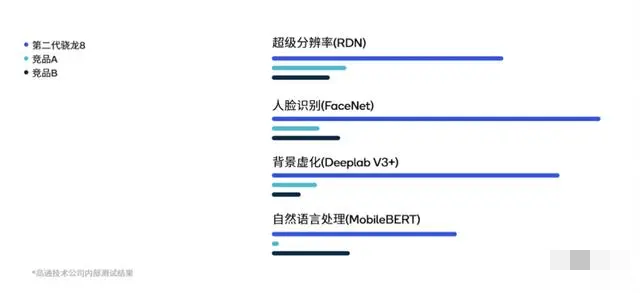

在硬件加速方面,以高通为例,其 AI 引擎中的关键核心 Hexagon 处理器采用了专用供电系统,支持微切片推理、 INT4 精度和 Transformer 网络加速等功能,既提高了性能,又降低了能耗和内存占用。

数据显示,Transformer 加速技术极大地提高了基于生成模型的 AI 中多头注意力机制的推理速度,在使用 MobileBERT 的特定用例中,AI 性能提升了 4.35 倍。

以稳定扩散为例,如今,高通的研究人员通过量化、编译和硬件加速优化,在搭载第二代骁龙 8 移动平台的手机上,可以以 15 秒 20 步的速度运行该模型,并生成 512×512 像素的图片。

经过手机的推理过程,完全不需要联网,在飞行模式下也能实现。部署这种 AI 技术并不容易,而高通为此准备了长达 2-3 年的时间,包括相关软件、工具和硬件方面的准备。

然而,现在,随着高通 AI 模型增效工具包、高通 AI 软件栈和高通 AI 引擎等软硬件工具的完备,高通仅用了不到一个月的时间,就在骁龙平台上实现了 Stable Diffusion 的高速运行,就像前文所述的那样。

也就是说,一旦基础技术准备就绪,包括大模型在内的生成式 AI 部署就会变得更加容易,我们不再难以想象"大模型部署到终端变成数字助手"这一情景,它不再是不可能的事情。

具体而言,通过将混合 AI 和软件 AI 技术应用于硬件上的“双重”架构,大模型可以部署在手机等终端设备中,并根据用户的习惯不断优化和更新用户画像,从而增强和打造个性化的生成式 AI 提示。这些提示将在终端设备上进行处理,只在必要时将任务转移到云端。

Ziad 进一步解释道:

“云不了解你,但终端设备了解你。如果模型可以在设备上进行微调,那它的功能将非常强大。”

“这也是突破大模型幻觉和记忆瓶颈的方式之一。高通可以做到通过一系列技术让大模型在不联网的情况下,借助终端设备数据长时间提供“专属”服务,同时也保护了用户隐私。”

值得关注的是,Ziad 还透露,除了 Stable Diffusion 和 ControlNet 外,基于高通全栈式的软件和硬件能力,研究人员正将更多的生成式 AI 模型迁移到手机中,模型参数量也正朝着百亿级别不断发展。

“很快,你就会在终端上看到像 LLaMA 7B / 13B 这样的模型。一切工具已经就绪,剩下的只是时间问题。”

而且,尽管目前只能在终端上部署"特定"的大模型,但随着技术的日益成熟应用,可以部署的大模型数量、模态类型和部署方式将极速演进。Ziad 指出:

“随着更多更好的 AI 算法被开源出来,我们也能更快地沿用这套软硬件技术将它们部署到终端侧,这其中就包括文生视频等各种多模态 AI。”

这意味着,未来用户有可能将自己喜欢的大模型迁移至手机端,使其成为超级助手的核心。

大模型加速涌向移动端!ControlNet 手机出图只需 12 秒,高通 AI 掌门人:LLaMA 也只是时间问题 - Extfans”